Meta encerrou o programa de verificação de fatos, permitindo que conteúdos considerados problemáticos sejam ‘corrigidos’ pelos próprios usuários. Especialistas alertam que postagens de ‘menor gravidade’ poderão permanecer no ar sem verificação, estimulando desinformação e discursos de ódio. Meta, dona de Instagram e Facebook, encerrará sistema de checagem de fatos

A Meta, dona do Instagram e do Facebook, decidiu encerrar seu programa de verificação de fatos para concentrar esforços apenas em conteúdos considerados de “alta gravidade”.

A mudança, que começa pelos Estados Unidos, foi anunciada pelo “chefão” da empresa Mark Zuckerberg em um vídeo de 5 minutos publicado no Instagram na última terça-feira (7).

Na publicação, Zuckerberg disse ainda que suas plataformas passarão a recomendar mais conteúdo político e que a equipe de “confiança, segurança e moderação de conteúdo”, que revisa posts de usuários dos EUA, deixará a Califórnia, um estado considerado progressista, e será realocada no Texas, governado por conservadores do Partido Republicano, o mesmo do presidente eleito Donald Trump.

Especialistas consultados pelo g1 alertam que a alteração na moderação de conteúdo permitirá que posts considerados problemáticos apareçam com mais frequência e permaneçam no ar sem a verificação da empresa, como desinformação sobre vacinas, Covid e eleições.

Nesta reportagem, você vai saber:

Como funcionava o sistema de checagem

E como fica a partir de agora?

Postagens antes barradas agora podem aparecer

Como funcionava o sistema de checagem

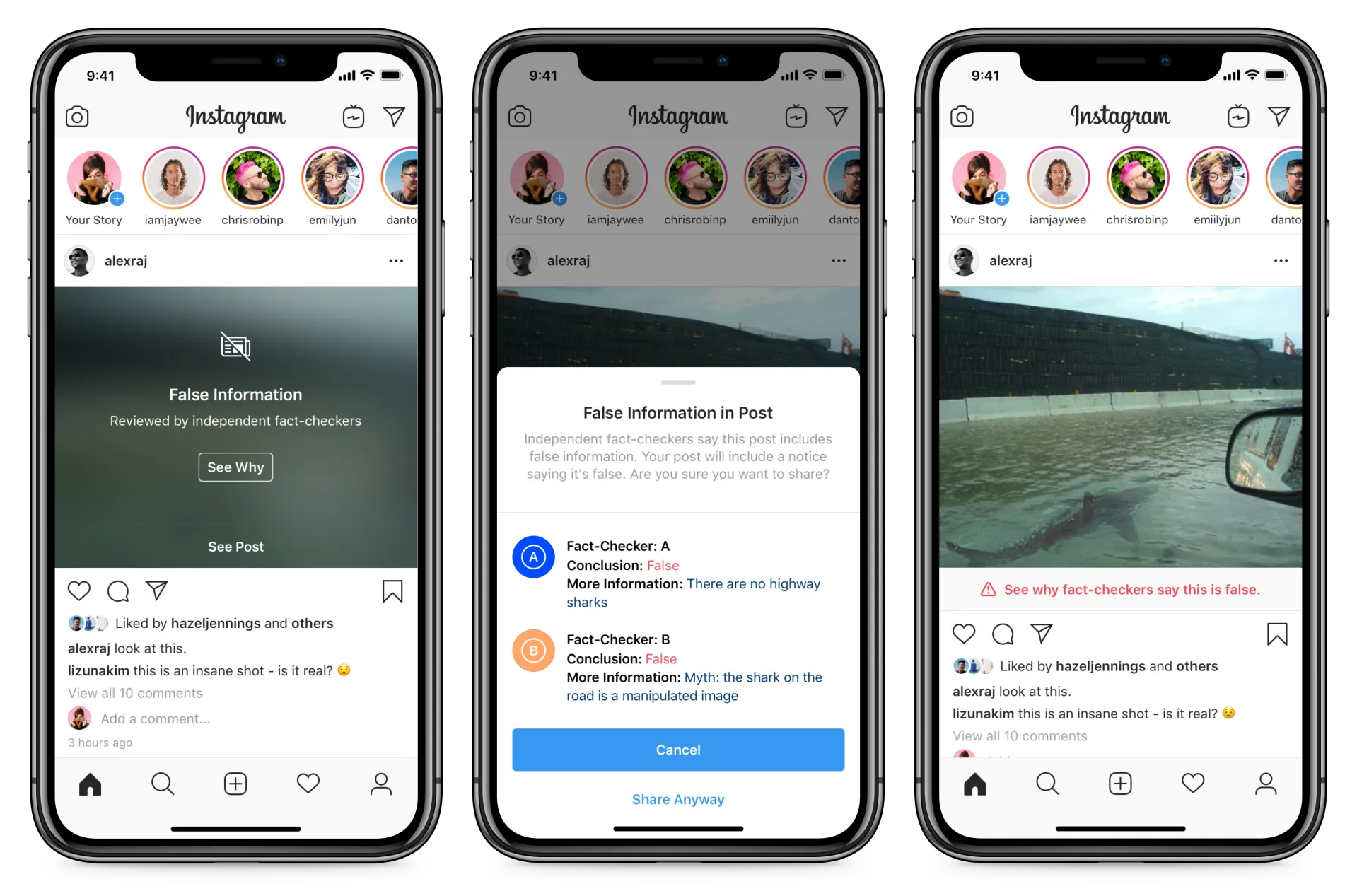

Instagram mostrou, em 2019, como seriam os avisos feitos por checadores independentes em posts conteúdo que tivessem alguma desinformação

Reprodução/Instagram

A moderação de conteúdo da Meta começou em 2016, após a vitória de Donald Trump nas eleições dos EUA. Na época, o Facebook foi acusado de ajudar a eleger Trump ao permitir que uma empresa usasse dados da base de usuários da rede social para espalhar notícias falsas.

O caso ficou conhecido pelo nome da companhia, Cambridge Analytica e chegou a gerar prejuízos financeiros para a plataforma de Zuckerberg. além de uma intenção pressão pública e até de funcionários do Facebook pelo combate à desinformação.

ENTENDA: o vai e vem na relação de Zuckerberg e Trump

De acordo com especialistas, para combater as fake news, a empresa criou a biblioteca de anúncios, estabeleceu um conselho com participação social e implementou o programa terceirizado de checagem de fatos, com organizações de fora da Meta, visando aumentar a transparência com seus usuários.

Quem eram os checadores – para fazer parte do programa da Meta, todos os checadores precisavam ser certificados e seguir os princípios da International Fact-Checking Network (IFCN), uma aliança global de checagem de fatos do Instituto Poynter, baseado nos EUA.

Desde 2016, mais de 80 organizações, atuando em mais de 60 idiomas, colaboravam com a empresa de Mark Zuckerberg. As agências de notícias Reuters, France Presse e Associated Press eram alguns desses parceiros.

No Brasil, a Meta conta com o apoio de cinco parceiros de checagem de fatos.

Esses parceiros podiam analisar materiais publicados no Instagram e no Facebook, abrangendo vídeos, imagens, links e textos.

Os parceiros de verificação tinham autonomia para identificar conteúdos suspeitos, mas, antes disso, equipes da própria Meta identificavam postagens virais com potencial de conter informações imprecisas.

Os checadores independentes avaliavam a precisão das publicações por meio de entrevistas com fontes primárias, análise de dados públicos e verificação de fotos e vídeos, segundo a própria Meta.

Os checadores que atuavam em parceria com a Meta não tinham autoridade para remover conteúdos, segundo Yasmin Curzi, pesquisadora do Karsh Institute of Democracy da Universidade de Virgínia (EUA).

Após a apuração, os parceiros notificavam a Meta sobre o problema no conteúdo. A big tech, então, decidia entre tirar a postagem do ar, reduzir o alcance — fazendo com que menos pessoas a vissem — ou exibir rótulos para alertar que havia algo errado naquele post, como nos exemplos abaixo.

Post de Trump no Facebook, em 2020, quando ele questionava o resultado da eleição de Joe Biden, recebeu aviso da Meta com a confirmação de quem tinha sido o vencedor das eleições

Reprodução/Facebook

“Existe ainda outro grupo de parceiros chamado ‘Trusted Flagger’ (sinalizadores de confiança). No entanto, esses participantes também não têm autoridade para remover conteúdos. Eles possuem maior capacidade de diálogo com a Meta, permitindo acelerar o processo de verificação”, explica Yasmin.

Também há um comitê de supervisão da Meta, chamado de Oversight Board, um órgão independente, que funciona como uma espécie de alta corte em que usuários podem apelar sobre a remoção ou recolocação de conteúdo no Facebook e no Instagram (não vale para o WhatsApp, pois as mensagens trocadas são criptografadas).

LEIA TAMBÉM:

O que são as notas de comunidade que a Meta quer implementar?

Meta passa a permitir que público LGBTQIA+ seja associado a doenças mentais

E como fica a partir de agora?

Exemplo de notas da comunidade do X

Reprodução/X

Com o fim das parcerias de verificação de fatos, em conteúdos de “menor gravidade” os próprios usuários poderão adicionar correções aos posts, como complemento ao conteúdo, de forma semelhante ao que é feito no X (veja exemplo acima).

Em vez de pegar qualquer violação à política do Instagram e do Facebook, os filtros de verificação passarão a focar em combater violações legais e de alta gravidade.

Para casos de menor gravidade, as plataformas dependerão de denúncias feitas por usuários, antes de qualquer ação ser tomada pela empresa.

Em casos de conteúdos considerados como de “menor gravidade”, os próprios usuários poderão adicionar correções aos posts, como complemento ao conteúdo.

Zuckerberg também anunciou que os filtros de verificação serão ajustados e aprimorados para se tornarem mais eficientes e precisos na análise antes de decidir pela remoção de um conteúdo.

É #FAKE que spray de alga trate ou previna disfunção erétil

Postagens antes barradas agora podem aparecer

Para Yasmin Curzi, da Universidade de Virgínia (EUA), todos os conteúdos que não podem ser compreendidos como “explicitamente ilegais e violações de alta severidade” poderão aparecer, “compreendendo não só desinformação, mas também racismo e homotransfobia”, diz.

“Pelo comunicado do Zuckerberg, apenas tipos muito específicos, como pornografia infantil, seguirão sendo objeto de ações de contenção de desinformação”, diz Helena Martins, professora da Universidade Federal do Ceará (UFC) e integrante da Coalizão Direitos na Rede.

A Meta contribuiu com a Organização Mundial da Saúde durante a pandemia de Covid, na luta contra a desinformação. No fim de 2021, a empresa divulgou que tinha removido 1 milhão de postagens no Brasil por desinformação sobre a Covid, desde o início da pandemia, em março de 2020. A plataforma avaliava esses conteúdos pelo potencial de risco à saúde.

Em 2022, durante a campanha eleitoral, a empresa fez acordo com o Tribunal Superior Eleitoral (TSE) para combater notícias falsas. Entre agosto e outubro, relatou ter derrubado 600 mil conteúdos por violência e discurso de ódio.

Entre as postagens estavam as que informavam horários e locais errados para votação até as que tentavam convencer pessoas a irem votar armadas. E também ofensas contra nordestinos.

Yasmin afirma que, com as mudanças anunciadas na última terça, desinformações sobre vacinas, Covid, eleições, ataques à democracia e instituições, além daquelas que atacam pessoas LGBTQIA+ e mulheres (teorias misóginas de inferiorização de gênero ou de medicalização desses grupos) também deverão ter mais espaço no Instagram, Facebook e Threads.

No mesmo dia em que avisou sobre o fim da checagem, a Meta alterou a política contra discurso de ódio de Instagram, Facebook e Threads, permitindo que orientação sexual e gênero sejam associados a doenças mentais. E liberando ofensas “no contexto de discussão de tópicos políticos ou religiosos, como ao discutir direitos transgêneros, imigração ou homossexualidade”.

“Estamos testemunhando o fim de um avanço significativo”, diz Clara Iglesias Keller, líder de pesquisa em tecnologia, poder e dominação no Instituto Weizenbaum, na Alemanha.

“As notas da comunidade podem ser importantes em algum grau, mas, ao excluir os checadores de fato do processo, a pouca influência externa que havia também é eliminada, o que pode reduzir ainda mais a transparência”, disse.

Mark Zuckerberg anuncia que Meta vai encerrar sistema de checagem de fatos

Mark Zuckerberg, CEO da Meta

Drew Angerer / AFP

WhatsApp começa a liberar recurso que converte áudios em textos; veja como usar

iPhone 16 é lançado com novo botão para controlar a câmera; veja preços no Brasil